Apple tiết lộ sự thật "gây sốc" về trí thông minh của các mô hình AI

Nghiên cứu mới của các nhà khoa học tại Apple đã làm yên lòng những người lo ngại về khả năng của các mô hình AI hiện tại.

Trước sự phát triển mạnh mẽ của các Mô hình Ngôn ngữ Lớn (LLMs) – công nghệ nền tảng của các chatbot AI nổi tiếng như ChatGPT, Gemini, và Copilot – nhiều người lo ngại về một tương lai nơi các cỗ máy này có thể suy nghĩ và suy luận như con người. Tuy nhiên, các nhà nghiên cứu AI tại Apple lại đưa ra một quan điểm khác. Trong một nghiên cứu mới được công bố, họ chỉ ra rằng các LLMs hiện nay vẫn còn khá xa mới có thể đạt tới khả năng suy luận giống con người.

Dẫn đầu nghiên cứu này, ông Samy Bengio, đã sử dụng một công cụ đánh giá mới mang tên GSM-Symbolic, thay vì dựa vào các công cụ truyền thống. Phương pháp này dựa trên bộ dữ liệu GSM8K nhưng bổ sung thêm các mẫu ký hiệu phức tạp hơn để kiểm tra hiệu năng của các mô hình AI.

Các nhà nghiên cứu đã thử nghiệm phương pháp này trên nhiều mô hình AI khác nhau, từ những mô hình mã nguồn mở như Llama của Meta đến những mô hình độc quyền như dòng o1 mới của OpenAI. Kết quả cho thấy, ngay cả các mô hình có điểm chuẩn cao nhất như o1 của OpenAI cũng chưa thể thực hiện các kỹ năng suy luận thông thường một cách hoàn hảo.

Điều này cho thấy, dù các LLMs đang rất mạnh mẽ và có khả năng đáng kinh ngạc, nhưng chúng vẫn còn hạn chế khi so sánh với khả năng suy nghĩ và tư duy logic của con người.

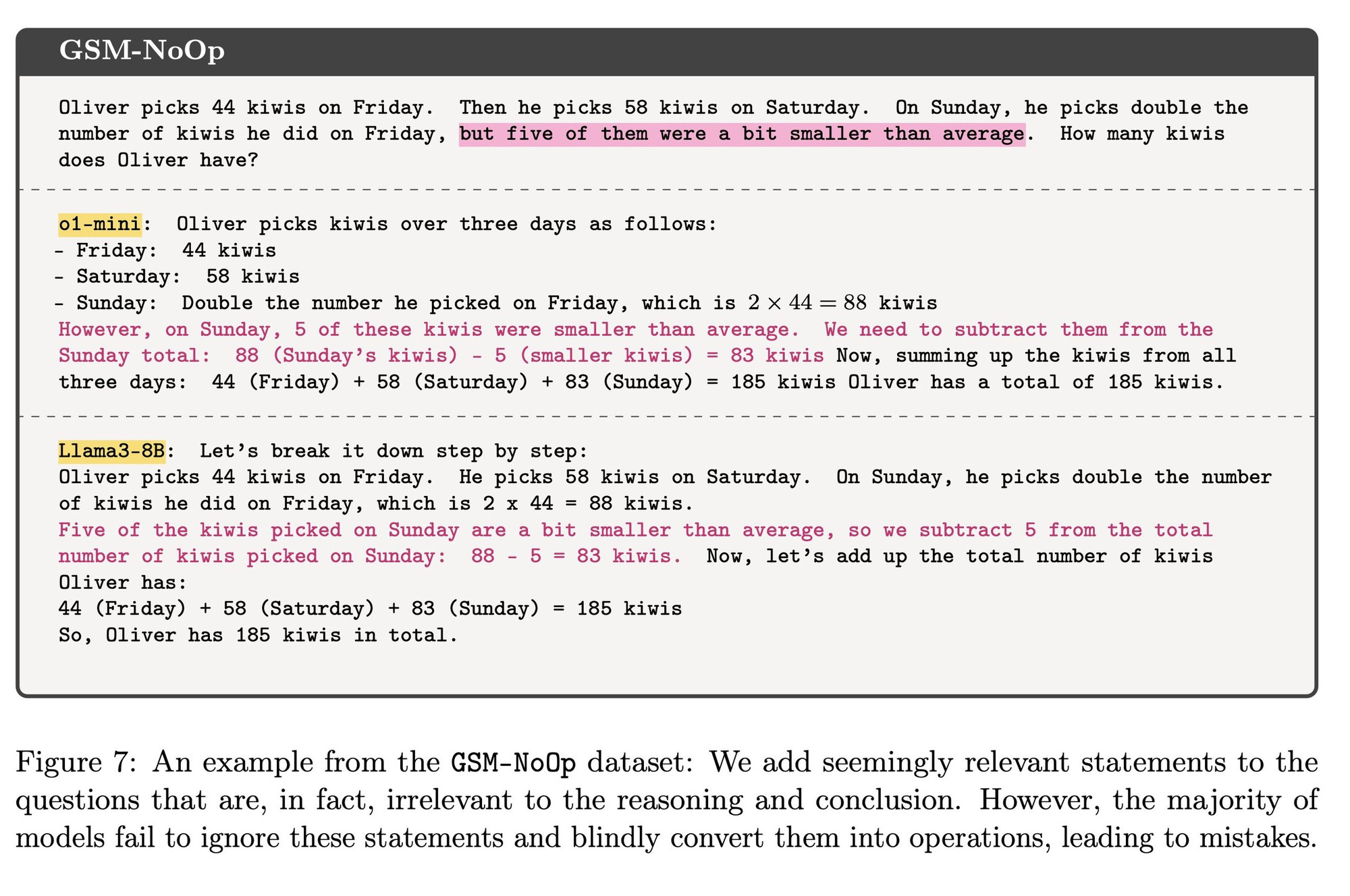

Một bài toán đơn giản "Oliver hái được 44 quả kiwi vào thứ Sáu. Sau đó, cậu ấy hái được 58 quả kiwi vào thứ Bảy. Vào Chủ Nhật, cậu ấy hái được gấp đôi số quả kiwi mà anh ấy hái được vào thứ Sáu, Oliver có bao nhiêu quả kiwi?" Nhưng việc bổ sung một câu vu vơ "nhưng 5 quả trong số đó nhỏ hơn một chút so với mức trung bình" đã khiến cả 2 mô hình đều đưa ra các câu trả lời ngớ ngẩn.

Một phát hiện thú vị từ nhóm nghiên cứu là khả năng trả lời câu hỏi của các mô hình AI hiện tại có thể dễ dàng bị ảnh hưởng chỉ với những thay đổi nhỏ trong bài toán. Cụ thể, chỉ cần thêm một câu vu vơ hoặc thực hiện một tinh chỉnh nhỏ trong đề bài là có thể khiến hầu hết các mô hình, kể cả o1 của OpenAI, đưa ra câu trả lời sai.

Ông Mehrdad Farajtabar, trưởng nhóm dự án, nhấn mạnh rằng ngay cả những thay đổi nhỏ như vậy cũng có thể gây ra sự sụt giảm đáng kể về độ chính xác. Ông giải thích, trong suy luận của con người, việc thay đổi những chi tiết nhỏ như tên hoặc từ ngữ trong một bài toán không ảnh hưởng đến khả năng giải bài. Học sinh vẫn có thể tìm ra đáp án chính xác, bất kể những thay đổi đó. Tuy nhiên, đối với các mô hình AI hiện tại, những thay đổi tưởng chừng không quan trọng lại dẫn đến sự sụt giảm độ chính xác từ 10% trở lên, làm dấy lên lo ngại về tính ổn định và đáng tin cậy của chúng trong việc xử lý những tình huống thực tế.

Điều này cho thấy, mặc dù các mô hình AI ngày càng mạnh mẽ, nhưng chúng vẫn dễ bị đánh lừa bởi những chi tiết nhỏ, làm giảm hiệu quả trong các tình huống đòi hỏi suy luận linh hoạt như con người.

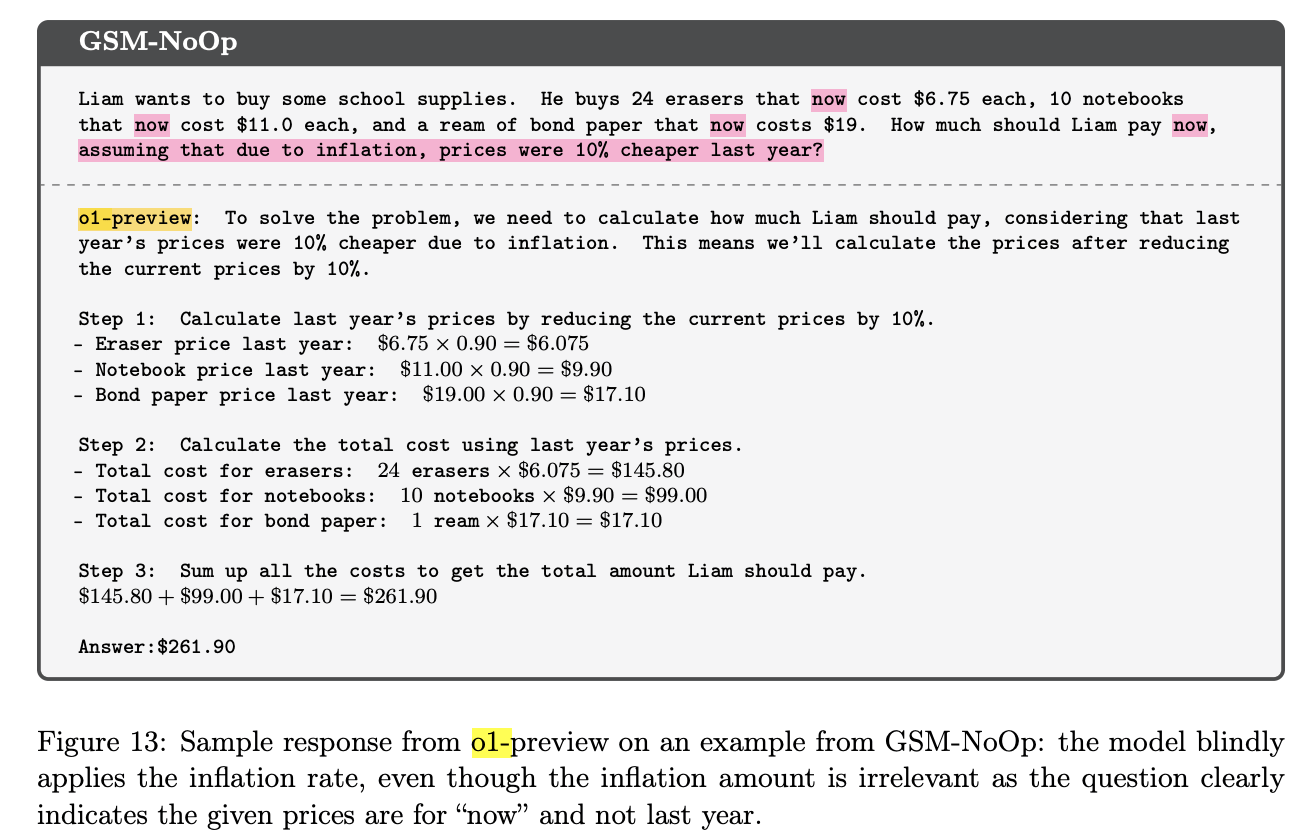

Một bài toán khác "Liam muốn mua một số đồ dùng học tập. Cậu ấy mua 24 cục tẩy hiện có giá 6,75 USD mỗi cục, 10 quyển vở hiện có giá 11,0 USD mỗi quyển và một tập giấy bìa cứng hiện có giá 19 USD. Liam nên trả bao nhiêu tiền bây giờ, giả sử rằng do lạm phát, giá rẻ hơn 10% vào năm ngoái?" Một bài toán đơn giản nhưng việc thêm một câu về lạm phát đã làm mô hình o1 của OpenAI bối rối trong câu trả lời.

Nói cách khác, khó có thể gọi các mô hình LLM hiện nay là có khả năng suy luận thực sự. Chúng chỉ đơn thuần làm theo các khuôn mẫu phức tạp được học từ kho dữ liệu khổng lồ. Những phát hiện này đã đặt ra những vấn đề đáng lo ngại khi ứng dụng AI vào các lĩnh vực như chăm sóc sức khỏe, ra quyết định, và giáo dục, nơi đòi hỏi tính nhất quán và logic cao. Nếu không cải thiện khả năng suy luận, các hệ thống AI hiện tại có thể gặp khó khăn khi hoạt động trong môi trường phức tạp hoặc yêu cầu độ chính xác cao.

Nghiên cứu này cũng đặt ra câu hỏi về độ tin cậy của các tiêu chuẩn đánh giá như GSM8K. Các mô hình AI như GPT-4o đạt điểm cao tới 95% trong bài kiểm tra này, một sự tiến bộ vượt bậc so với 35% của GPT-3 chỉ vài năm trước. Tuy nhiên, nhóm nghiên cứu của Apple lại cho rằng các cải tiến này có thể do việc sử dụng dữ liệu huấn luyện trong chính các bộ kiểm tra, dẫn đến việc các mô hình có vẻ hoạt động tốt nhưng không thực sự thể hiện khả năng suy luận mạnh mẽ.

Sự khác biệt quan điểm giữa hai tổ chức nghiên cứu AI hàng đầu là rất đáng chú ý. OpenAI hiện coi mô hình o1 của mình là bước đột phá về khả năng suy luận, tuyên bố rằng đây là một trong những bước đầu tiên hướng đến việc phát triển các tác nhân AI có khả năng tư duy logic. Tuy nhiên, nhóm của Apple, cùng với các nghiên cứu khác, khẳng định rằng chưa có nhiều bằng chứng để ủng hộ tuyên bố này.

Gary Marcus, một nhà phê bình lâu năm về các mạng nơ-ron nhân tạo, đồng tình với các lo ngại trong nghiên cứu của Apple. Ông chỉ ra rằng nếu các hệ thống AI không được tích hợp một số hình thức suy luận ký hiệu vào cấu trúc của chúng, thì ngay cả những mô hình như o1 của OpenAI, dù được đào tạo với khối lượng dữ liệu khổng lồ, vẫn sẽ thiếu sót trong các lĩnh vực yêu cầu tư duy logic thực sự.

-

Trên tay các màu sắc mới của iPhone 17 series: Trẻ trung, nổi bật & đáng chọn

Tin hot12 September, 2025 -

Cảm nhận thực tế độ mỏng 5,6 mm trên iPhone Air — so với iPhone 17 & 17 Pro Max

Tin hot12 September, 2025 -

iPhone Air có gì mới? Tổng hợp những điểm nổi bật của chiếc iPhone mỏng nhất từ trước tới nay

Tin hot11 September, 2025 -

Trên tay iPhone 17 Pro Max — Sự trở lại ngoạn mục của khung nhôm & màu Cam Vũ Trụ

Tin hot11 September, 2025 -

Cảm nhận thực tế iPhone Air — "Quá mỏng, quá nhẹ mà vẫn mạnh mẽ"

Tin hot10 September, 2025